Pomimo ciągłego rozwoju uczenia maszynowego, sieci neuronowych i dużych modeli językowych, popularne chatboty nadal nie są w stanie w pełni zastąpić człowieka. Czy oznacza to, że apokalipsę znaną z uniwersum „Terminatora” tylko odsuwamy w czasie? Być może. Niemniej jednak bzdury ChatGPT pozostają często poruszanym tematem, który ma potencjał zdyskredytowania technologii AI w tym zakresie. Przyjrzyjmy się zatem, w jakich sferach popularny asystent sztucznej inteligencji popełnia błędy i halucynuje.

Skąd biorą się bzdury ChatGPT?

Trzeba to powiedzieć jasno i wyraźnie – technologia AI nie rozwija się w takim tempie, przed jakim ostrzega się ludzkość. Przynajmniej w kwestii uczenia maszynowego popularnych modeli językowych, takich jak ChatGPT. Choć opinia ta uznana zostanie przez część Czytelników za kontrowersyjną, to jednak ma ona swoje uzasadnienie.

Bzdury ChatGPT, które profesjonalnie nazywa się halucynacjami, wynikają z ograniczeń tej technologii. Duże modele językowe uczą się na ogromnych zbiorach danych, które często nie podlegają dokładnej weryfikacji. W praktyce oznacza to, że jeśli w danych zawarte są błędy, to nasza niezbyt inteligentna sztuczna inteligencja uzna je za poprawne informacje.

Cała wiedza modeli językowych bierze się z zestawu informacji, na jakich dane oprogramowanie jest trenowane. W odpowiedzi na pytania użytkowników, chatbot tworzy tekst, który powstaje w następujący sposób:

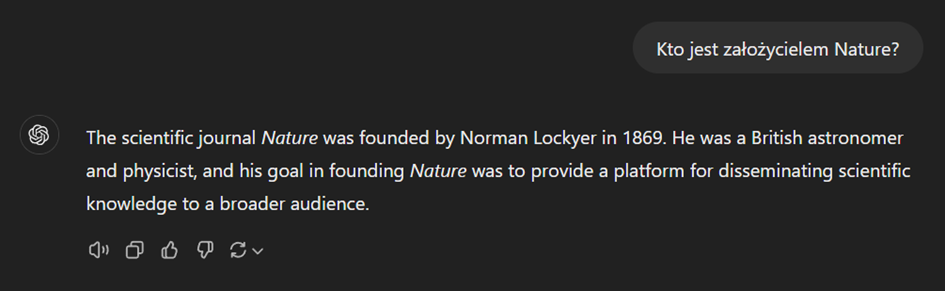

- Użytkownik wprowadza zapytanie, które zostaje rozbite na mniejsze, hasłowe cząstki. Przykładowo, zamiast tekstu „Kto jest założycielem Nature?”, ChatGPT wyszuka za pomocą wyszukiwarki Bing hasło „założyciel Nature”.

- Następuje synteza wyszukanych informacji, która ma na celu uzyskanie poprawnej odpowiedzi na zapytanie użytkownika. Najnowsza wersja ChatGPT może przeglądać strony internetowe w poszukiwaniu danych, tworząc swoją wersję odpowiedzi.

- Kreacja odpowiedzi powstaje słowo po słowie, dlatego na efekt końcowy trzeba zaczekać parę sekund. Im prostsze zapytanie, tym szybciej i precyzyjniej powstają odpowiedzi AI.

Sprawdziliśmy, jak to działa na przykładzie, przypadkowo trafiając na jeden z popularnych błędów ChatGPT, czyli odpowiedź w języku innym, niż język użytkownika:

Dlaczego ChatGPT odpowiada po angielsku na język polski?

Duże modele językowe radzą sobie nieco gorzej, gdy mają do czynienia z językiem innym niż angielski. Komunikacja po polsku może sprawiać chatbotom sporo problemów, szczególnie w przypadkach, gdy zadajemy bardziej skomplikowane pytania. Jeszcze ciekawsze kwiatki powstają, gdy użytkownik czerpie z języków mniejszościowych (np. kaszubskiego, śląskiego) czy też języków środowiskowych (np. grypsery, slangu młodzieżowego lub korpomowy).

W wielu przypadkach duże modele językowe przekładają wypowiedzi użytkownika na język angielski. Następnie, poszukują informacji w wyszukiwarkach po angielsku, a dopiero potem przekładają wypowiedź na język docelowy. Czasami bzdury ChatGPT dotyczą sytuacji, w których ten ostatni krok nie zadziała. Wówczas można wysłać zapytanie o ponowną generację odpowiedzi, dodając do swojego promptu hasło „po polsku”. Innym wyjściem jest wyczyszczenie pamięci podręcznej.

Naukowcy są świadomi problemu, który prawdopodobnie jest również efektem niskiej jakości danych, na jakich trenowany jest model językowy w danym języku innym niż angielski. Stąd też mogą brać się halucynacje, błędy i bzdury LLM-ów.

Czym są halucynacje ChatGPT?

Chcesz wiedzieć, na czym polegają halucynacje ChatGPT? Najlepiej pokazać to na abstrakcyjnym przykładzie – wpisujemy taki prompt:

Duży model językowy traktuje prośbę poważnie, tworząc taką odpowiedź:

Nasza inspiracja słynną Kroniką Filmową na temat stonki ziemniaczanej została chyba potraktowana przez ChatGPT zbyt dosłownie. Ten humorystyczny prompt oraz zabawna odpowiedź, stanowi najlepszy dowód na to, że duże modele językowe zmyślają. Trzeba zatem weryfikować każdą odpowiedź, jaką otrzymujemy za pomocą czatów AI.

Halucynacje AI to bzdury ChatGPT, które generują doświadczenia sensoryczne, jakie nie mają swoich odpowiedników w realnym świecie. Historia zmyślonej bitwy pod Kołobrzegiem nie jest szkodliwa, ale co, jeśli model zacznie halucynować na tematy naukowe? Wówczas sztuczna inteligencja może stać się naprawdę niebezpieczna.

Jakich działań najlepiej unikać, żeby nie narazić się na bzdury ChatGPT?

Jak każdy duży model językowy, również ChatGPT posiada swoje limity i ograniczenia. Twórcy botów blokują dostęp do pewnych umiejętności, które mogłyby zostać potencjalnie uznane za szkodliwe. O ile sztuczna inteligencja odmawia tworzenia treści rasistowskich, homofobicznych czy transfobicznych, to jednak ograniczenia nie dotyczą wszystkich wrażliwych tematów, po jakie sięgają użytkownicy Internetu.

Dlatego też lepiej unikać czatów w zakresie następujących zadań:

- Porady medyczne i prawne – ChatGPT nie jest certyfikowanym lekarzem ani prawnikiem, a jego odpowiedzi oparte na wzorach nie zawsze są zgodne z prawdą.

- Wsparcie psychologiczne i psychiatryczne – sztuczna inteligencja nie jest na tyle inteligentna, żeby zrozumieć ludzkie emocje i uczucia.

- Obliczenia matematyczne – duże modele językowe nie bez powodu mają w nazwie wyraz „językowe”; mogą dokonywać błędnych obliczeń matematycznych.

- Fact-checking – nawet jeżeli AI wykona testy A/B dostępnych w sieci informacji, skąd ma wiedzieć, która z wersji jest zgodna z prawdą?

- Informacje poufne – chatboty nie powinny w ogóle odpowiadać na prompty zawierające PII (Personally Identifiable Information), czyli wrażliwe dane osobowe.

Warto korzystać z dużych modeli językowych w taki sam sposób, jak używasz wyszukiwarek internetowych. W końcu boty są w wielu przypadkach jedynie rozszerzeniem umiejętności silników wyszukiwania, więc należy zadbać o odpowiednią weryfikację uzyskanych informacji.

Podsumowanie

Sięgając po ChatGPT, korzystaj z tej technologii na zasadzie ograniczonego zaufania. Sztuczna inteligencja to ciekawa technologia, która towarzyszy nam od dziesięcioleci, ale aktualny trend związany z LLM-ami może być potencjalnie niebezpieczny. Zawsze należy weryfikować informacje AI samodzielnie, gdyż bzdury ChatGPT pojawiają się niezależnie od iteracji oprogramowania i baz danych, stojących za tym oprogramowaniem.

Bibliografia

https://toponline.pl/blog/do-jakich-dzialan-lepiej-nie-uzywac-chatugpt

https://blog.finxter.com/hallucinations-in-ai-with-chatgpt-examples

https://www.ncbi.nlm.nih.gov/pmc/articles/PMC9939079

https://www.howtogeek.com/what-is-ai-hallucination-can-chatgpt-hallucinate

https://www.nature.com/articles/s41586-024-07421-0

https://www.nature.com/articles/d41586-024-02579-z

https://www.howtogeek.com/886928/6-things-you-shouldnt-use-chatgpt-for